Pédophilie, zoophilie et violence extrême : dans l'enfer de Facebook

Son travail était simple, mais peu seraient capables de le supporter aussi longtemps qu'elle: le site Business Insider a publié lundi 9 (voir ici) le témoignage de Sarah Katz, une jeune femme qui travaillé pendant huit mois (en 2016) pour Vertisystem, un prestataire de Facebook. L'entreprise est chargée de la modération des messages postés sur le réseau social et qui ont été repérés comme problématiques. C'est une intervention humaine réalisée par l'un des 4.500 modérateurs chargés du tri qui permet au post d'être publié ou d'être écarté.

Et la jeune femme décrit un travail à la fois monotone, et qui l'a mise aux prises avec les images les plus atroces auxquelles échappent les utilisateurs de Facebook. Chaque jour, l'employée de Vertisystem devait faire face à l'horreur au rythme d'une image toutes les dix secondes –soit 8.000 chaque jour– où se succèdaient dans le meilleur des cas de la pornographie, et dans le pire des cas des images pédophiles, des rapports sexuels zoophiles ou des actes de violence extrême.

Sarah Katz se souvient notamment de l'impuissance dans la durée face aux images pédopornographiques, une lutte sans fin: "L’image pouvait être supprimée puis revenir sur un compte différent. Un jour venant du Pakistan, un autre jour venant des Etats-Unis. C’est un job monotone après un certain temps. Et vous finissez par être désensibilisé à ce type d’images parce que vous en voyez trop".

La jeune femme ne critique d'ailleurs pas ses conditions de travail: un open-space à Menlo Park au cœur de la Silicon Valley en Californie (où est aussi implantée Facebook), et une ambiance de "franche camaraderie" entre collègues. Mais un travail pour lequel elle a dû signer une déclaration où elle acceptait de voir des images "dérangeantes" et devait prévenir sa direction si elle ne pouvait plus le supporter. Ce qui fut visiblement le cas.

Voir aussi - Twitter fait la chasse aux "fake news": un million de comptes suspendus par jour

Elle explique d'ailleurs au site être toujours hantée par une série d'images revenant régulièrement en boucle et montrant deux petits enfants d'une dizaine d'années, nus sous la taille et se touchant mutuellement, semblant obéir à des ordres donnés par la personne capturant les images.

Facebook peine à faire face aux torrents d'images atroces postées par certains de ses 2,2 milliards d'utilisateurs. L'entreprise a annoncé l'embauche de 3.000 nouveaux modérateurs.

D'après les chiffres du réseau social, sur les trois premiers mois de l'année 2018, Facebook a supprimé 3,4 millions de messages contenant de la violence, 21 millions contenant du sexe, 1,9 million contenant de la propagande terroriste. Comme d'autres réseau social, Facebook a aussi purgé les faux comptes gérés par des robots ou publiant des "fake news" ce qui entraîné la désactivation de 583 millions de comptes.

À LIRE AUSSI

L'article vous a plu ? Il a mobilisé notre rédaction qui ne vit que de vos dons.

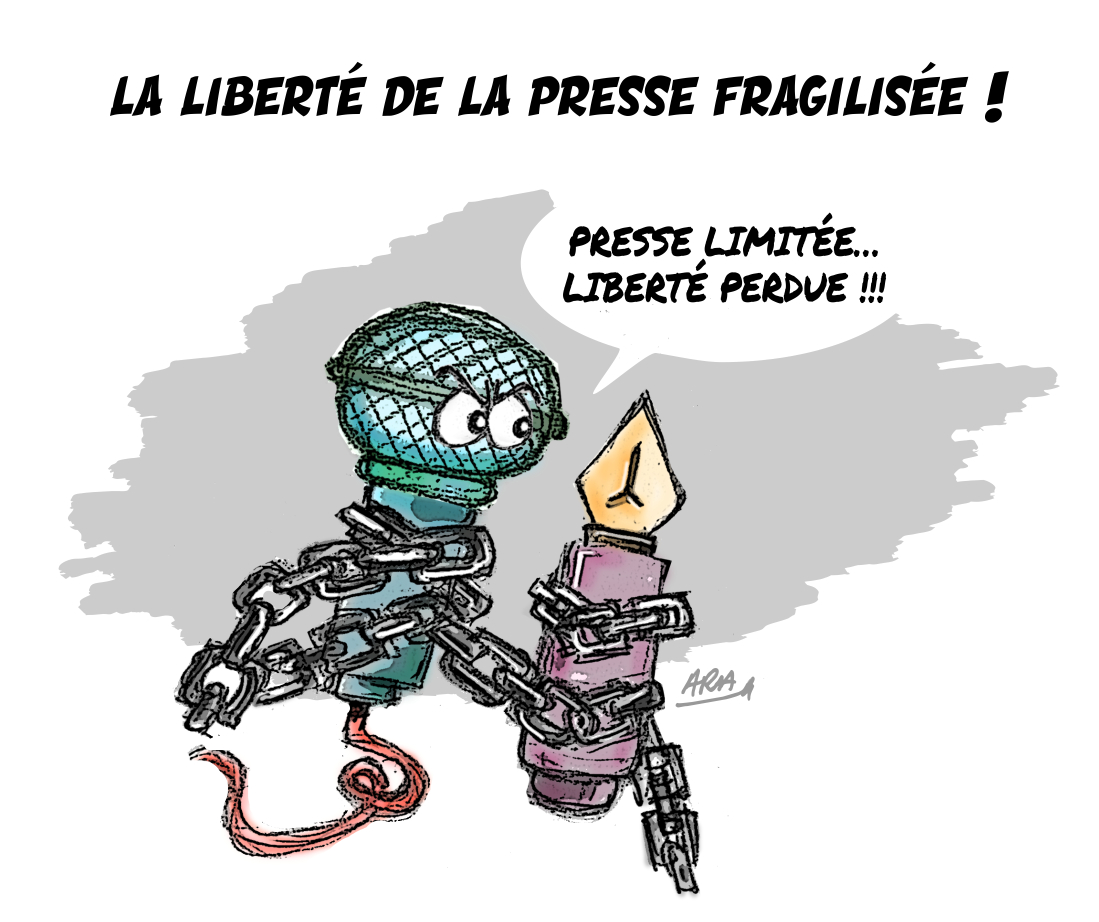

L'information a un coût, d'autant plus que la concurrence des rédactions subventionnées impose un surcroît de rigueur et de professionnalisme.

Avec votre soutien, France-Soir continuera à proposer ses articles gratuitement car nous pensons que tout le monde doit avoir accès à une information libre et indépendante pour se forger sa propre opinion.

Vous êtes la condition sine qua non à notre existence, soutenez-nous pour que France-Soir demeure le média français qui fait s’exprimer les plus légitimes.

Si vous le pouvez, soutenez-nous mensuellement, à partir de seulement 1€. Votre impact en faveur d’une presse libre n’en sera que plus fort. Merci.