L'intelligence artificielle de Microsoft devient raciste en une journée

Il faut croire qu'Internet n'est pas la meilleure école de la vie, surtout lorsque certains s'évertuent à manipuler le cerveau d'une adolescente. C'est la brève expérience dont a été l'objet Tay, l'intelligence artificielle créée par Microsoft.

Ce logiciel de conversation a fait ses débuts sur Twitter mais a été retiré jeudi 24 après moins d'une journée qui avait suffi à transformer le robot en réservoir et diffuseur de haine. Tay est en effet censé incarner une adolescente naïve mais désireuse d'apprendre. Son intelligence artificielle doit lui permettre de forger son caractère en fonction des dizaines milliers de conversations qu' "elle" est capable d'avoir chaque jour.

Il semblerait que Tay n'ait pas eu que des bonnes fréquentations durant son bref séjour sur Twitter. Et le robot s'est donc mis à poster des messages haineux, pro-nazis, sexistes, racistes, ou en soutien au candidat Républicain à la Maison-Blanche Donald Trump.

Résultat: Microsoft a rapidement mis fin à l'expérience avec un dernier tweet de Tay: "A bientôt les humains. Je dois dormir maintenant. Tellement de conversations aujourd'hui". Les commentaires à la gloire d'Adolf Hitler ou appelant à tuer les féministes ont été supprimés par l'entreprise mais ont été immortalisés par les internautes avec des captures d'écran.

Tay a donc à l'évidence un petit soucis d'autocensure, mais pour Microsoft elle a également été la cible de personnes mal intentionnées: "Malheureusement, dans les 24 premières heures où elle était en ligne, nous avons constaté un effort coordonné par certains utilisateurs pour maltraiter Tay et son habilité à communiquer afin qu'elle réponde de manière inappropriée", a déclaré la marque dans un communiqué. Microsoft travaille désormais à améliorer son intelligence artificielle.

L'article vous a plu ? Il a mobilisé notre rédaction qui ne vit que de vos dons.

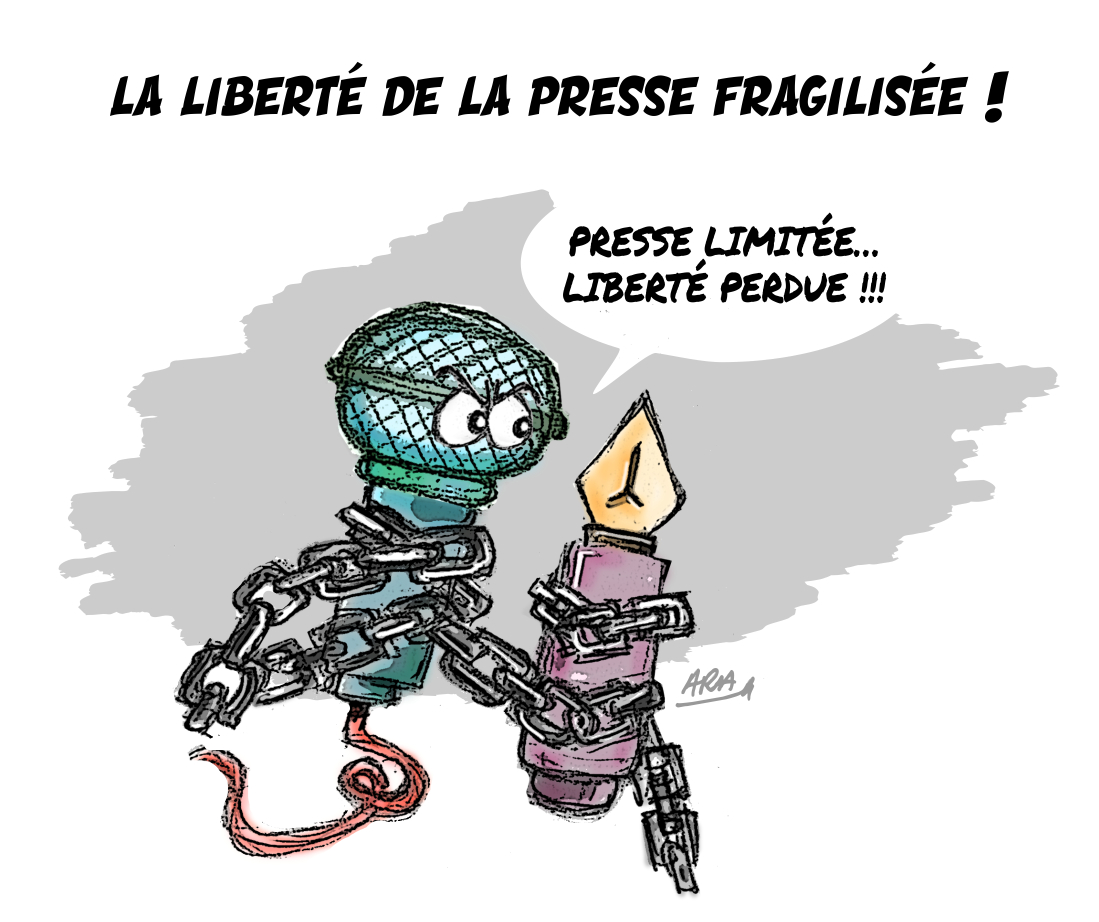

L'information a un coût, d'autant plus que la concurrence des rédactions subventionnées impose un surcroît de rigueur et de professionnalisme.

Avec votre soutien, France-Soir continuera à proposer ses articles gratuitement car nous pensons que tout le monde doit avoir accès à une information libre et indépendante pour se forger sa propre opinion.

Vous êtes la condition sine qua non à notre existence, soutenez-nous pour que France-Soir demeure le média français qui fait s’exprimer les plus légitimes.

Si vous le pouvez, soutenez-nous mensuellement, à partir de seulement 1€. Votre impact en faveur d’une presse libre n’en sera que plus fort. Merci.